TDE 2011

Wydarzenia > Tarnowskie Dni Elektryki

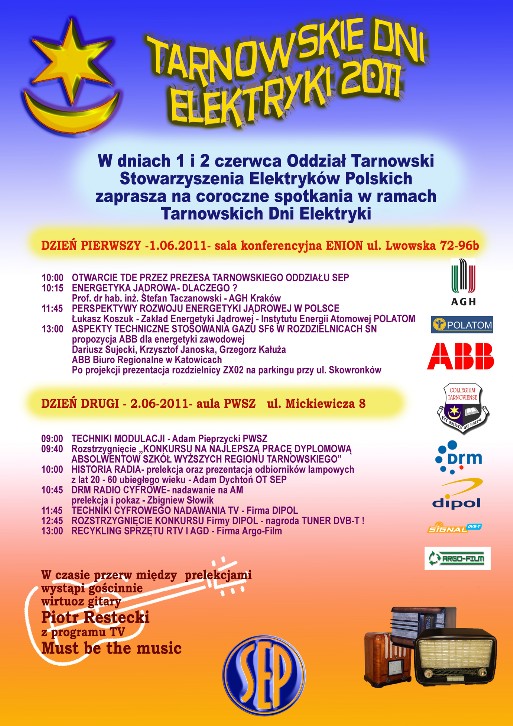

Tarnowskie Dni Elektryki 2011

Tegoroczne Tarnowskie Dni Elektryki zostały zorganizowane przez Oddział Tarnowski SEP w dniach od 1-2 czerwca br. W pierwszym dniu zaproszeni goście i uczestnicy TDE spotkali się na Sali Błękitnej - wtedy Oddziału Tarnowskiego ENION S.A dzisiaj już Oddziału TAURON Dystrybucja S.A.. Otwarcia TDE dokonał Prezes OT SEP Antoni Maziarka, który po przywitaniu przybyłych i wstępnym zagajeniu przedstawił prowadzącego ten pierwszy dzień, kol. Aleksandra Gawryała.

Spotkanie zainaugurował prof. dr hab. inż. Stefan Taczanowski z Akademii Górniczo-Hutniczej w Krakowie wykładem „Energetyka jądrowa - dlaczego?”, w którym przedstawił podstawy fizyczne działania reaktorów jądrowych, ich budowę, poruszył zagadnienia związane z bezpieczeństwem ich funkcjonowania, jak również odniósł się do głośnych katastrof w energetyce jądrowej takich jak katastrofa w Czarnobylu, czy katastrofa, która miała ostatnio miejsce w Japonii w Fukushimie. W czasie wykładu przewijały się różne wątki, również m.in. ten, że niektóre z krajów europejskich stawiają na energetykę jądrową, a inne z nich jak chociażby Niemcy chcą ją zlikwidować do 2022 roku, demontując wszystkie reaktory jądrowe. Profesor mówił również o bezpieczeństwie energetycznym kraju w pespektywie przewidywanego zapotrzebowania na energię elektryczną, również zapotrzebowaniu na różne surowce energetyczne - paliwa - potrzebne do produkcji energii elektrycznej. Poruszone zostały także zagadnienia związane z napromieniowaniem ludzi wykonywanym w medycynie w celach leczniczych.

Po wykładzie zostały skierowane do prelegenta pytania, z których można było się dowiedzieć, że obecnie energetyka jądrowa daje w skali świata ok. 16 % energii elektrycznej, że od końca lat osiemdziesiątych ubiegłego wieku następuje regres energetyki jądrowej, gdyż w latach osiemdziesiątych poprzedniego stulecia energetyka jądrowa dawała 20 % energii elektrycznej. W wiodącym technologicznie w świecie kraju takim jakimi są Stany Zjednoczone w okresie dwudziestu pięciu lat wybudowano tylko jedną nową elektrownię jądrową ( na marginesie trzeba zaznaczyć, że jej budowa była planowana dużo wcześniej i stan zawansowania prac wymusił jej zakończenie w tym okresie czasu ). Zmiany w energetyce jądrowej polegają obecnie jedynie na modernizacji obiektów istniejących. W Polsce środowisko rządowe planuje budowę elektrowni jądrowej składającej się z dwóch bloków energetycznych o mocy 1300 MW każdy, które mają być oddane do eksploatacji po 2022 roku - będą one dawać energetyce krajowej ok. 6% mocy dostępnej. W pytaniach poruszono również zagadnienia związane z odpadami jądrowymi i recyklingiem zużytego paliwa jądrowego.

W odpowiedzi uzyskano informację, że z odpadów można wyodrębniać uran i pluton, które mogą posłużyć jako paliwo w elektrowniach jądrowych, lecz pozostałą część odpadów w zupełności nie da się przetworzyć na „produkty” użyteczne i bezpieczne dla człowieka i środowiska naturalnego i pozostają one jako „śmieci”, które gdzieś trzeba magazynować. Również w elektrowniach jądrowych nie wykorzystuje się tzw. ciepła odpadowego. Padło również pytanie o miniaturyzację elektrowni jądrowych - jednak w opinii profesora jest to generalnie niemożliwe, choć niektóre elementy mogą być w miarę zastosowania nowych technologii nieco mniejsze. Na koniec padło pytanie, czy w perspektywie likwidacji elektrowni jądrowych w Niemczech do 2022 r. budowa elektrowni jądrowej w Polsce, która do tego czasu na pewno nie powstanie, nie zakończy się na wskutek protestów społecznych, czy np. pod wpływem dyrektyw Unii Europejskiej zamknięciem nowo wybudowanej elektrowni i będziemy mieli podobną historię do Żarnowca, gdzie utopiono ciężkie miliardy złotych, a elektrownia nie powstała. Profesor zaczął zastanawiać się czy kraj taki jak Francja pozwoli sobie na zamknięcie swoich kilkudziesięciu elektrowni jądrowych. Jedynie czas może zweryfikować praktycznie postawione pytania i dać wszystkim rzeczywiste odpowiedzi.

Łukasz Koszuk z Zakładu Energetyki Jądrowej Instytutu Energetyki Atomowej POLATOM ze Świerka pod Warszawą, jedynego w kraju jądrowego ośrodka naukowo-badawczego, przedstawił wykład zatytułowany „Perspektywy rozwoju energetyki jądrowej w Polsce”. Ośrodek oprócz działalności naukowo-badawczej prowadzi również produkcję izotopów do celów medycznych i technicznych. Również zajmuje się edukacją społeczną w swojej dziedzinie prowadząc fundację „Forum Atomowe” skupiającą młodych pasjonatów energetyki jądrowej z całej Polski ( grupa liczy ok. 30 osób ).

Na rozwój energetyki jądrowej w Polsce składa się wiele aspektów i działań w różnych dziedzinach nauki i techniki, które muszą być zrealizowane, aby powstała choćby tylko jedna elektrownia jądrowa. W Polsce jak mówił prelegent w zasadzie zaczynamy od zera. Po pierwsze nie ma w Polsce wykształconej kadry, która kiedyś była, lecz po zamknięciu budowy elektrowni w Żarnowcu w latach 80-tych ubiegłego wieku w większości opuściła nasz kraj lub przebranżowiła się. Ten sam problem dotyczy dozoru jądrowego. Prelegent wymienił kilka podstawowych warunków, które muszą być spełnione, aby energetyka jądrowa w Polsce mogła zaistnieć i funkcjonować. Na początku muszą być stworzone ramy prawne, na podstawie, których będzie tworzona i funkcjonowała, następnie musi ponownie powstać dozór jądrowy, musi zostać przygotowany i wdrożony program kształcenia kadry, muszą zostać przeprowadzone analizy lokalizacyjne budowy elektrowni j ądrowej i muszą powstać składowiska odpadów promieniotwórczych, również musi powstać odpowiednie zaplecze naukowe, oraz musi nastąpić rozbudowa energetycznej sieci przesyłowej i powstać program rozpoznawania zasobów uranu w Polsce. Zakłada się, że powinna być przeprowadzona kampania informacyjna, aby uzyskać przychylność społeczeństwa polskiego do tych działań i zamierzeń. Wiele z tych elementów wymaga intensywnych, kosztownych i wieloletnich działań. Aktualnie w Polsce mamy trzy obiekty jądrowe. Są to reaktor badawczy Maria i dwa przechowalniki wypalonego paliwa jądrowego. Wszystkie te obiekty znajdują się na terenie ośrodka w Świerku. Do 1995 r. funkcjonował jeszcze jeden obiekt, reaktor Ewa, który został w całości zdemontowany.

Uczestnicy TDE dowiedzieli się również o tym, że aby przeszkolić specjalistę w zakresie energetyki jądrowej wymagane jest pięć lat studiów technicznych lub fizycznych i pięć lat specjalistycznego szkolenia pod jeden konkretny reaktor jądrowy. Obecnie rozpoczęto już szkolenie edukatorów we Francji, która lobbuje za sprzedażą swoich reaktorów Polsce. Łącznie w roku 2009 i 2010 przeszkolono 45 osób. Podczas prelekcji przedstawiono również strukturę zatrudnienia personelu, która w liczbie ok. 800 osób potrzeba jest do funkcjonowania elektrowni jądrowej z jednym blokiem energetycznym. Jak to zostało zaznaczone niekoniecznie spowoduje to wzrost zatrudnienia na rynku pracy, ale może być wręcz odwrotnie jeśli przyszły inwestor z różnych powodów w miejsce lokalnej, polskiej siły roboczej, najmie jako operatora elektrowni jądrowej obcą specjalistyczną firmę - a takie firmy już funkcjonują na świecie - zdolną utrzymać w ruchu przyszłą elektrownię jądrową.

Według założeń rządowych w Polsce ma być uruchomiona tzw. kampania edukacyjno-informacyjna, ale do tej pory nie wyłoniono z przetargu firmy, która by j ą przeprowadziła. Prelegent podał, że jak wskazują badania opinii publicznej po katastrofie w Fukushimie o kilka procent spadło poparcie społeczne do budowy elektrowni jądrowej w Polsce. W ramach edukacji fundacja działająca w Świerku uruchomiła tzw. „Atomowy autobus”, który zaczął już jeździć po Polsce mając na celu przekonywanie lokalnych społeczności do projektu budowy elektrowni jądrowych w Polsce. Instytut Energii Atomowej POLATOM organizuje również Szkołę Energetyki Jądrowej, w której zajęcia są bezpłatne, bo koszty z tym związane pokrywają sponsorzy. Jak prelegent zaznaczył opór społeczności lokalnych szczególnie na Pomorzu, gdzie potencjalnie może być zlokalizowana elektrownia jądrowa jest bardzo duży i patrząc w kontekście katastrofy w Fukushimie akcja edukacyjno-informacyjna może być spóźniona i bardzo trudna. W 2010 roku zorganizowano akcję polegającą na zgłaszaniu się do Ministerstwa Gospodarki gmin, które chcą, aby na ich terenie zlokalizować elektrownię jądrową. Zgłosiło się 28 gmin, które zostały uszeregowane wg. opracowanych kryteriów. Najkorzystniejszymi lokalizacjami okazały się kolejno Żarnowiec, Warta-Klempicz, Kopań, Nowe Miasto, Bełchatów, Nieszawa, Tczew, Choczewo, Połaniec i Chotcza.

Polska posiada jedno składowisko odpadów nisko radioaktywnych pochodzących z medycyny i przemysłu w Różanie, które zapełni się już w niedługim czasie. Dlatego do 2020 roku konieczne jest wybudowanie nowego składowiska, które nie będzie jednak składowiskiem dla odpadów wysoko radioaktywnych z elektrowni jądrowej. Odpady takie będą składowane na terenie elektrowni przez kilkadziesiąt lat tj. pięćdziesiąt do sześćdziesięciu lat, do czasu aż ostygną, a później mają na mocy międzynarodowego układu o nierozprzestrzenianiu materiałów radioaktywnych wrócić do producenta paliwa.

Kwestia bezpieczeństwa związana jest z typem reaktora - w Polsce dyskutuje się nad dwoma typami reaktorów PWR i BWR, które różnią się zasadniczo obiegami chłodzenia - pierwszy posiada trzy, a drugi dwa obiegi chłodzenia. W generatorze BWR skażona para wodna wychodzi poza obudowę bezpieczeństwa generatora, a w generatorze PWR dzięki trzeciemu obiegowi na turbiny kierowana jest para nieskażona. Omówione zostały również pożądane cechy bezpieczeństwa jakie powinny posiadać współczesne reaktory jądrowe trzeciej generacji, tak aby były bezpieczniejsze od dotychczas stosowanych - jak na razie na świecie wybudowano jedynie w Japonii jeden reaktor jądrowy trzeciej generacji, a pozostałe eksploatowane reaktory są reaktorami co najwyżej drugiej generacji. Reaktory trzeciej generacji różnią się od wcześniejszych reaktorów tym, że posiadają specjalne chwytacze stopionego rdzenia znajdujące się pod zbiornikiem bezpieczeństwa, które pozwalają w przypadku stopienia rdzenia wychwycić spływający materiał w całości.

Również prelegent odniósł się do bezpieczeństwo energetyki w kontekście wydarzeń w Czarnobylu i Fukushimie opisując procesy jakie zaszły podczas tych katastrof.

Na koniec padły pytania. Jedno dotyczyło mocy reaktora Maria i jego pracy. Uczestnicy mogli usłyszeć, że moc cieplna reaktora wynosi 30 MW i że reaktor służy do celów badawczych, ale przede wszystkim do produkcji radioizotopów dla medycyny, które wysyłane są na cały świat. Z tego względu pracuje on w cyklach tygodniowych, dwutygodniowych i miesięcznych. O jego znaczeniu może świadczyć fakt, że ostatnio w związku z awarią reaktorów badawczych w Kandzie i Holandii był jedynym miejscem na świecie, gdzie produkowano molibden, z którego z kolei powstaje technet stosowany w medycynie nuklearnej o czym pisały gazety na całym świecie. Kolejne pytanie wiązało się z aspektami ekonomicznymi produkcji izotopów dla celów medycznych. Z uzyskanych informacji uczestnicy TDE dowiedzieli się, że efekty ekonomiczne nie przekładają się działalność naukową, gdyż pożytki z produkcji czerpie specjalnie w tym celu powołana spółka. Kolejni prelegenci z ABB Krzysztof Janoska i Dariusz Sudecki zaprezentowali referat „Aspekty techniczne zastosowania gazu SF6 w rozdzielnicach SN” . Omówione zostały właściwości gazu SF6, który w rozdzielnicach ABB stosowany jest jako medium izolacyjne, a nie czynnik gaszący łuk. W przypadku zastosowania SF6 do gaszenia łuku elektrycznego, gaz ulega rozpadowi na związki toksyczne i nie jest obojętny dla otoczenia w przypadku jego uwolnienia do środowiska, pomimo tego, że rekombinuje do postaci pierwotnej SF6. Gaz SF6 ma bardzo dobre właściwości izolacyjne, lepsze od powietrza ok. 2,5 raza, co pozwala na zmniejszenie gabarytów budowanych urządzeń. Jest nietoksyczny i niepalny, cięższy pięć razy od powietrza, jego charakterystyka nie ulega zmianie w czasie eksploatacji przewidzianej przez producenta rozdzielnic na 30 lat, podlega on recyklingowi po okresie eksploatacji, nie stwarza zagrożenia dla warstwy ozonowej, jego ubytek w eksploatowanych urządzeniach wynosi 0,01 % na rok co jest grubo poniżej obowiązującej normy, która podaje wielkość 0,1 % na rok. Firma jest m.in.

producentem wyłączników VD4 i rozdzielnic ZX do których komory próżniowe produkuje fabryka w Ratingen w Niemczech. Rozdzielnice z SF6 są mniej kłopotliwe w eksploatacji od rozdzielnic powietrznych, bardziej odporne na czynniki zewnętrzne gdyż wykonane są w klasie ochronności (izolacji) IP 65, są bardziej bezpieczne dla obsługi, prostsze do instalacji. Rozdzielnice ZX pracują przy nadciśnieniu 0.3 bara i poziom bezpiecznej izolacji jest osiągany również przy nadciśnieniem równym 0.0 bara. Rozdzielnice wyposażone są w czujniki gęstości gazu z zabezpieczeniem łukoochronnym, Naprawa ich jest możliwa również w miejscu ich zainstalowania poprzez specjalne klapy rewizyjne przez firmowy serwis, który posiada urządzenie do spuszczenia i napełnienia gazu SF6. Możliwa jest również wymiana całego wyłącznika. W dalszej części prezentacji przedstawiono szczegółowo budowę i różne konfiguracje rozdzielnicy SN ZX0.2.

Na koniec spotkania miała miejsce prezentacja przed budynkiem dyrekcji byłego ZE Tarnów tej rozdzielnicy wykonanej z wykorzystaniem izolacji gazowej.

W kolejnym dniu uczestnicy TDE zgromadzili się w Auli Państwowej Wyższej Szkoły Zawodowej w Tarnowie. Przybyłych powitał Prezes OT SEP Antoni Maziarka, kierując tytułem wstępu kilka słów na temat Stowarzyszenia Elektryków Polskich, Oddziału Tarnowskiego i prowadzonej przez Oddział działalności. Drugi dzień TDE został przygotowany i poprowadzony przez kol. Zbigniewa Papugę, który na początku omówił w kilku słowach program tego dnia, oraz zapowiedział występy gościnne Piotra Rosteckiego z Kielc wirtuoza gitary programu TV „Must be the music”, który w przerwach uświetniał program tego dnia.

Następnie Adam Pieprzycki z PWSZ w Tarnowie, przedstawił referat „Techniki modulacji”, w którym w popularnonaukowym ujęciu omówił to podstawowe, ale wcale niełatwe ze względu na różne odmiany, zagadnienie z dziedziny przesyłu sygnału i informacji. W zależności od sposobu modulacji sygnał można propagować na bliższe lub dalsze odległości, sposób modulacji ma również wpływ na efektywne wykorzystanie pasma sygnału. Bez modulacji jednym kanałem przesyłowym możliwe jest przesyłanie tylko jednego sygnału. Modulację zasadniczo dzieli się na modulację ciągłą czyli analogową, impulsową i cyfrową. Modulację ciągłą dzieli się na modulację amplitudową i kątową, a tą zaś z kolei na modulację częstotliwości i fazy. Natomiast modulację impulsową dzieli się na modulację cyfrową i analogową, którą z kolei dzieli się na modulację amplitudy impulsów, szerokości impulsów, położenia impulsów i gęstości impulsów. Modulacja cyfrowa dzieli się na kilkanaście typów, z których modulacja typu M-QAM znalazła zastosowanie w telefonii komórkowej. Każda z modulacji ma swoje zalety, cechy i wady, które zostały omówione szczegółowo przez prelegenta.

Następnie punktem programu TDE było ogłoszenie laureatów tegorocznego „Konkursu na najlepszą pracę dyplomową absolwentów wyższych szkół technicznych regionu tarnowskiego”, który od wielu lat organizowany jest przez OT SEP. Wyniki konkursu przedstawił Grzegorz Bosowski, przewodniczący Komisji

Konkursowej, zaś wręczenia przyznanych nagród dokonał Prezes OT SEP Antoni Maziarka.

Do konkursu zostało zgłoszonych pięć prac, które zostały podzielone na dwie grupy tematyczne. W dziedzinie elektroenergetyki komisja nagrodziła pracę dyplomową Pana Krystiana Dybasia „Trójfazowe transformatory trójuzwojeniowe - praca w warunkach niesymetrii zewnętrznej”, której promotorem był dr hab. inż. Jerzy Skwarczyński, zaś w dziedzinie automatyki i elektroniki nagrodzona została praca Pana Rafała Mroczka „Opracowanie projektu urządzeń do rejestracji położenia geograficznych obiektów mobilnych”, której promotorem był dr inż. Jacek Kołodziej. Przyznano również wyróżnienie, które otrzymał Pan Tomasz Brożek za pracę dyplomową „Opracowanie układu diagnostyki i sterowania blokiem wzmacniaczy strefowych”, której promotorem był również jak poprzednio dr inż. Jacek Kołodziej.

Kolejną prelekcję na temat historii radia przedstawił kol. Adam Dychtoń. Towarzyszyła jej rewelacyjna wystawa różnych radioodbiorników radiowych przygotowana przez tarnowskich krótkofalowców. Właścicielem najstarszych prezentowanych radioodbiorników pochodzących z lat dwudziestych i trzydziestych ubiegłego wieku jest Zbigniew Wilczyński, członek Polskiego Związku Krótkofalowców.

Historia radia była bardzo burzliwa i związane są z nią nazwiska wielu sławnych osób. Rozpoczyna się ona w 1873 roku kiedy swoją teorię fal elektromagnetycznych publikuje James Maxwell. Już dziesięć lat później w 1884 roku zostaje wynaleziony przez włoskiego fizyka Onesti detektor, który zostaje ulepszony później w latach 1884-1886 roku przez francuskiego naukowca Branly’ego. W 1886 roku niemiecki fizyk Hertz potwierdza eksperymentalnie teorię fal elektromagnetycznych Maxwella. Z powstaniem przekazu radiowego wiąże się również nazwisko Brytyjczyka Lodge, który dokonuje pierwszego przekazu radiowego alfabetem Morse’a wykorzystując ulepszony detektor Branly’ego. Amerykanin serbskiego pochodzenia Tesla, uzyskuje w 1893 roku pierwszy na świecie patent na urządzenie transmisji radiowej. Z początkami radia związane są również nazwisko rosyjskiego fizyka Popowa, który przeprowadza w Petersburgu w 1896 roku publiczny pokaz przekazu radiowego na skromnym jak na dzisiejsze czasy dystansie 250 m i Włocha Marconiego, który w tym samym roku organizuje publiczny przekaz radiowy dla brytyjskiej Admiralicji. Marconi w 1896 roku uzyskuje patent brytyjski na radio i otwiera w 1898 roku pierwszą fabrykę produkująca urządzenia radiowe. Pomiędzy Teslą i Marconim toczy się wojna o patent na radio, którą przed amerykańskim sądem przegrywa Tesla. W 1943 roku amerykański sąd ponownie przyznaje Tesli prawo do patentu na radio, ale jest to już tzw. musztarda po obiedzie, gdyż wynalazca, posiadacz ponad 300 patentów już nie

żyje.

Dalszy rozwój radia jest burzliwy. Dzięki wynalazkowi Szweda Ernsta Aleksandra, który konstruuje w 1904 roku maszynę wirującą wytwarzająca prąd przemienny wysokiej częstotliwości do 100 kHz możliwe jest wybudowanie nadajnika radiowego modulowanego amplitudowo. W 1906 roku, 24 grudnia w Wigilię Świąt Bożego Narodzenia statki na morzu odebrały pierwszą audycję radiową - radiooperatorzy mogli usłyszeć graną na skrzypcach „Holly Night” i fragment czytanej Biblii przez kanadyjskiego inżynier Fessendera, który nadawał po raz pierwszy mowę i muzykę z Brant Rock w Massachusetts. Od tej pory, bo aż do 1920 roku, kiedy to skonstruowano pierwszy lampowy nadajnik radiowy, przy pomocy tego urządzenia Aleksandra możliwe było nadawanie sygnałów radiowych w postaci mowy i muzyki - wcześniejsze przekazy radiowe był przekazami telegraficznymi opartymi o alfabet Morse’a. W 1906 roku zostaje skonstruowana przez Brytyjczyka Fleminga dioda lampowa opatentowana w Stanach Zjednoczonych. Nieco później w tym samym roku Amerykanin De Forest konstruuje triodę, umożliwiając w ten sposób wzmacnianie sygnału. Użyteczność radia dostrzegają władze morskie Stanów Zjednoczonych - Kongres w 1910 roku uchwala ustawę wymagającą, aby wszystkie statki pasażerskie przewożące ponad 50 pasażerów i pływające dalej niż 200 kilometrów od wybrzeży były wyposażone w radio, a od 1912 roku kiedy zatonął Titanic nałożono na statki obowiązek utrzymywania stałej 24 godzinnej łączności z lądem.

W 1918 roku w oparciu o lampy próżniowe opracowane zostają przez Amerykanina Armstronga zasady odbioru superheterydowego, a w 1922 roku zostaje wybudowany pierwszy radiowy nadajnik superreakcyjny.

W 1920 roku pojawia się pierwsza komercyjna stacja radiowa w Westinghouse w Pittsburghu, W 1930 roku Armstrong uruchamia doświadczalną stację radiową z modulacją częstotliwości FM, którą patentuje w 1933 roku, zaś w 1937 roku otrzymuje pozwolenie na budowę stacji eksperymentalnejwydane przez Federal Communications Commission ( FCC ). Powstaje w ten sposób nowa jakość w historii radia związana z doskonalszym przekazem fonii przez radio, gdzie odbierany dźwięk jest czystszy niż słuchany z płyt gramofonowych. W 1940 roku zostaje przydzielone dla radia FM pasmo częstotliwości od 42 do 50 MHz, a w 1945 roku FCC przenosi pasmo nadawcze FM w zakres częstotliwości od 88 do 108 MHz.

W Europie po zakończeniu II Wojny Światowej w 1948 roku następuje nowy rozdział częstotliwości, w której nie biorą udziału okupowane Niemcy, co skutkuje tym, że nadają one później w zakresie fal UKF, bo brakuje dla nich przyznanych częstotliwości na zakresie fal krótkich.

W 1948 roku, bardzo szybko, bo w rok po wynalezieniu tranzystora pojawiają się pierwsze radia tranzystorowe. Kolejnym etapem w rozwoju radia są w latach 50- tych prace nad nadawaniem audycji stereofonicznych, a w końcu lat 70-tych zostaje opracowany turner radiowy FM z syntezą częstotliwości.

Z początkiem lat 90-tych ubiegłego wieku w Europie i niemal na całym świecie za wyjątkiem USA i Japonii zaczyna rozwijać się w oparciu o program „Eureka 147” radio cyfrowe DAB ( Digital Audio Broadcasting oparty na formacie MEPG-1 ). Amerykanie w 1991 tworzą tzw. HD Radio, system będący hybrydą radia analogowego i cyfrowego, polegający na jednoczesnym nadawaniu w fali nośnej

sygnału radiowego z częścią analogową i cyfrową, co pozwalało na odbiór tej samej audycji radiowej zarówno przez odbiorniki analogowe i cyfrowe. Zgodnie z założeniami twórców tej technologii w miarę upływu czasu udział sygnału analogowego miał maleć na rzecz sygnału cyfrowego, by w końcu zostać zastąpiony w całości przez sygnał cyfrowy.

Obecnie radio cyfrowe przeżywa rozkwit mutując w różnych jego odmianach takich jak np. XMS Radio i XMS Satelite Radio w USA, Digital Radio Mondiale w Europie, WordSpace, Media Star i inne.

Ta bardzo ciekawa prezentacja kol. Adama Dychtonia o historii radia zakończyła się pokazem na ekranie różnych radioodbiorników produkowanych jeszcze przed I Wojną Światową w USA, czy polskich radioodbiorników produkowanych w okresie międzywojennym przez firmę ELECTRIC z Wilna takich jak np. Pacyfik i Gloria. Zostały również pokazane radioodbiorniki produkowane po zakończeniu II Wojny Światowej w Diorze w Dzierżoniowie i w Zakładach Radiowych Kasprzaka w Warszawie. W Diorze w Dzierżoniowie produkowano takie znane kiedyś powszechnie radioodbiorniki jak Śląsk, Radiola, Podhale, czy produkowany od 1958 roku radioodbiornik Symfonia. W Zakładach Radiowych Kasprzaka w Warszawie od 1958 roku produkowano całą rodzinę odbiorników ZRK np. Cezar-Quadro.

Wiele radioodbiorników zostało pokazanych w auli PWSZ na przygotowanej specjalnie na okoliczność TDE wystawie.

Później Zbigniew Słowik w swoim referacie „DRM radio cyfrowe” mówił o nadawaniu na paśmie AM poniżej 30 MHz radiowego sygnału cyfrowego. Przyczyną powstania radia DRM były m.in. spadek liczby radiosłuchaczy radiofonii AM spowodowanych niską jakością reprodukowanego dźwięku spowodowanego przez stale rosnący poziom zakłóceń radiotechnicznych generowanych przez nowoczesne przetwornice impulsowe i cyfrową transmisję danych przewodami nieekranowanymi

i przejście większości słuchaczy radiowych na pasmo UKF FM, co doprowadziło do uwolnienia tego zakresu fal. W 1997 roku w Chinach w miejscowości Guangzhou spotkali się nadawcy, operatorzy sieci, producenci nadajników i odbiorników radiowych i przedstawiciele świata nauki i powołali organizację międzynarodową Digital Radio Mundiale, której zadaniem była cyfryzacja widma radiowego w zakresie częstotliwości poniżej 30 MHz. Organizacja ta liczy 93 członków i 90 członków zaprzyjaźnionych z 39 krajów świata. Z czasem zagospodarowano również częstotliwości powyżej 30 MHz i w ten sposób powstały dwa systemy określane jako odpowiednio DRM i DRM+.

Radio DRM cechuje się poprawą jakości dzięki unikalnym własnościom propagacji w paśmie poniżej 30 MHz, większym zasięgiem, umożliwiającym pokrycie całego kraju jednym nadajnikiem, cechuje się lepszym wykorzystaniem pasma niż w przypadku transmisji stereofonicznej FM, oraz dla radia DRM+ obniżeniem mocy przy porównywalnym zasięgu.

Standard ten został przyjęty i zatwierdzony w 2002 roku przez Międzynarodową Unię Telekomunikacyjną ( IUT ), a w roku 2003 przez Międzynarodową Komisję Elektrotechniczną ( IEC ) i Europejski Instytut Norm Telekomunikacyjnych (ETSI ). Standard DRM+ został przyjęty w 2009 roku.

Podczas prezentacji zostały omówione tryby transmisji sygnału DRM, parametry modulacji sygnału, tryby odpornościowe i omówiono praktyczne wykonanie odbiornika radiowego. Następnie zademonstrowano jak działa radio DRM na przykładzie symulowanego przy użyciu komputera odbioru kilku stacji radiowych nadających w tym standardzie. W tym standardzie nadają Niemcy, Anglicy, Rumuni, Rosjanie, ale nie Polacy pomimo, że jako kraj mamy przydzielone pasmo i jest ono dostępne do wykorzystania.

Tadeusz Szydłowski z firmy DIPOL w referacie „Techniki cyfrowe w nadawaniu TV” omówił w bardzo dynamicznym wykładzie zagadnienia związane z cyfrowym przekazem telewizyjnym z zastosowaniem medium jakim jest Internet i o perspektywach rozwoju najnowszych technik transmisji sygnału do odbiorców końcowych z zastosowaniem różnego rodzaju urządzeń odbiorczych.

Obecnie wchodzimy w drugą fazę rewolucji cyfrowej polegająca na migracji cyfrowych usług do sieci. Jednym z jej przejawów jest nadawanie telewizji cyfrowej, lecz nie jak dotychczas w formie rozsiewczej, ale jako telewizji IPTV dużej rozdzielczości. Najnowocześniejszy obecnie na świecie standard telewizji mają chińczycy. Jest to zintegrowany system DVB-T2 razem z telewizją mobilną nazwany DMB-T/H. Pozwala on odbierać telewizję nawet przy prędkości poruszania się 200 km/godz. W Europie mamy mieszaninę różnych systemów, a telewizja dużej rozdzielczości, ale w formie rozsiewczej wchodzi dopiero na rynek, co świadczy o zapóźnieniu technologicznym naszego kontynentu.

Podstawą drugiej fazy rewolucji cyfrowej będzie przetwarzanie informacji w tzw. chmurze komputerów ( claud computing ), skąd dostarczane będą różnego rodzaju usługi sieciowe, zaś cechą końcowego odbiorcy będzie praca terminalowa. Odbiorca końcowy poprzez laptopy, desktopy, tablety, smartfony i inne urządzenia terminalowe będzie łączył się z ogromnymi centrami danych skąd będzie czerpał informację

i różnego rodzaju usługi sieciowe. System usług sieciowych pozwoli odbiorcy na to, aby nie miał zainstalowanych u siebie programów, które użytkuje, jak również jego urządzenie końcowe np. komputer będzie mogło być pozbawione dysków, gdyż swoje dane będzie przechowywał w jakimś Data Center.

W chmurze komputerów będą przetwarzane i dostarczane usługi telewizyjne ( telewizja interaktywna iTV, telewizja przesyłana z zastosowaniem szerokopasmowego Internetu IPTV, telewizja otwarta OTT ), usługi telewizji na życzenie CCTV, M2M i usługi przeznaczone dla smartfonów i tabletów. Przykładem takiej usługi zaprezentowanej przez Microsoft może być przekazywanie pogody na świecie w czasie rzeczywistym. W telewizji interaktywnej to odbiorca będzie decydował o tym co będzie chciał oglądać, będzie miał on dostęp do usług wideo na żądanie ( VoD ), interaktywnych gier telewizyjnych, elektronicznych gazet, filmów YouTube, albumów zdjęć i.td. - odbiorca będzie dostawał takie same funkcje jak na komputerach.

Obecnie w Europie zaczyna rozwijać się telewizja hybrydowa, która polega na tym, że program nadawany jest przez satelitę, a pewne funkcje pobierane są z Internetu. W Niemczech od 2010 roku funkcjonuje hybrydowa telewizja HbbTV, gdzie sprzedano już 2 mln urządzeń pracujących w tym systemie, zaś w Wielkiej Brytanii od 14 lutego 2012 roku zacznie funkcjonować hybrydowa telewizja interaktywna YouView, która będzie bardziej zaawansowana niż niemiecka telewizja HbbTV i będzie współpracować z telewizjami Freesat i Freewiev. W tym roku ma rozpocząć działalność telewizja YouTobe, za pomocą której będzie można oglądać zarówno programy satelitarne jak i naziemne korzystając z funkcji interaktywnych.

Telewizja IPTV ( Internet Protocol Television ) to technologia oparta na przesyłaniu sygnału telewizyjnego z zastosowaniem protokołu IP do dedykowanych odbiorców. W Stanach Zjednoczonych w 2010 roku nastąpił znaczny spadek odbiorców telewizji kablowej (o 741 tyś abonentów ), natomiast nastąpił wzrost liczby abonentów płatnej telewizji satelitarnej o 145 tyś. i wzrost aż o 476 tyś. odbiorców nowej platformy telewizji IPTV.

Telewizja OTT ( Over-The-Top ) jest z kolei telewizją, gdzie transmisja odbywa się poza kanałami tradycyjnymi takimi jak telewizja naziemna, satelitarna i kablowa. Wykorzystuje ona Internet jako medium transmisji i może być odbierana na wszystkich urządzeniach, które pozwalają na korzystanie z Internetu, czyli na komputerach, telefonach i telewizorach wyposażonych w moduł internetowy. Używa ona uniwersalnych kodeków i uniwersalnych urządzeń. Najwięksi operatorzy telewizji OTT to m.in. Hulu w USA, Niederland 24 w Holandii, ABC iView w Australii, BBC Player, 4od, ITV Player , Demand Five w Wielkiej Brytani. Również Gogle zakłada telewizję OTT, która umożliwi nadawanie programów telewizyjnych przez niekomercyjnych nadawców i małe firmy. Oprogramowanie Media Server umożliwi transmisję lokalnych imprez, przekaz konferencji i.t.p.

Innym zastosowaniem telewizji są systemy CCTV . W Chinach w strefie przemysłowej Chongqing, gdzie mieszka i pracuje 32 miliony mieszkańców projektuje się zainstalowanie 500 tyś. kamer telewizyjnych, które będą śledziły na bieżąco życie w tej przemysłowej strefie.

W Europie projektowany jest podobny system CCTV o nazwie INDECT. Jednym z elementów tego systemu jest projekt wykorzystania krążących nad obszarem objętym INDECT-em bezpilotowych samolotów tzw. dromów, które w systemie rzeczywistym będą nadzorowały zachowania ludzi! Zarządzanie takimi systemami i prowadzenie analizy obrazów z tylu kamer będzie wymagało zastosowania tzw. systemów IVS ( Inteligent Video System ) o dużej mocy obliczeniowej, które w czasie rzeczywistym będą pozwalały na detekcję pozostawionych przedmiotów, śledzenie obiektów, rozpoznawanie twarzy, rozpoznawanie tablic rejestracyjnych, analizę zbyt długiego pozostawania osoby lub obiektu w obserwowanym polu, wykrywanie pożarów, liczenie ludzi, analizę natężenia ruch drogowego, analizę zachowań osób, kontrolę płynności ruchu, badanie zainteresowania.

W ramach systemów CCTV będą mogły być dostarczane usługi video zdalnego zarządzania i nadzoru VSaaS ( Video Surneillance as a Service ) i MvaaS ( Managed Video as a Service ) dla firm zewnętrznych, realizujących ochronę lub zarządzanie obiektów zlecone dla ich klientów.

Jedną z dostarczanych usług sieciowych jest również usługa i technologia M2M, która polega na tym, że dwa urządzenia komunikują się ze sobą bez udziału człowieka. Do 2015 roku przewiduje się wzrost ilości połączeń M2M z 87 milionów do 217 milionów i wzrost przychodów związanych z tą usługą dwukrotnie do 6,7 miliarda dolarów. Przykładem usługi M2M może być np. wykonanie sekwencji zdarzeń przed naszym powrotem z pracy do domu, po uprzednim ich zaprogramowaniu na komputerze czy smartfonie. Tematem tym zainteresowała się firma Intel, która w ramach projektu inteligentny dom ( Home Dashboard Concept ), tworzy system gdzie inteligentna jednostka centrala za pomocą protokołu ZigBee będzie sterowała peryferyjnymi urządzeniami domowymi. System ten dzięki podłączeniu z Internetem będzie umożliwiał ciągłą aktualizację wybranych informacji i zewnętrzne sterowanie systemem.

W Korei Południowej powstaje miasto New Sondo City tzw. Koreański Eden, w którym życie zostanie zorganizowane w oparciu o technologię M2M. Życie mieszkańców będzie odbywało się tam trochę pod dyktando różnych czujników, przetworników i analizatorów. Na przykład mieszkańcy tego miasta wyjeżdżając z domu będą kierowani do celu podróży niekoniecznie najprostszymi drogami, lecz drogami wyznaczonymi przez system. Innym przykładem organizacji życia w tym futurystycznym mieście będą reklamy, które będą emitowane przez system, który najpierw rozpozna płeć i następnie będzie kierował odpowiednią reklamę do kobiet jeśli rozpoznaną osobą będzie kobieta, a nie do mężczyzny itd. itp.

Według Google w najbliższych latach zestaw smartfon i „cloud computing” rewolucyjnie zmienią świat. Smartfon jako asystent człowieka ma tłumaczyć obce j ęzyki bezpośrednio w trakcie rozmowy, podawać dane o korkach ulicznych, rozpoznawać obiekty, wyszukiwać najbardziej atrakcyjne oferty handlowe, przekazywać obrazy telewizyjne najwyższej jakości łącznie z obrazami 3D, co ma nastąpić już pod koniec tego roku. Jaka będzie cena takiej usługi, to na razie nie wiadomo. Google udostępniło na swojej witrynie portal z filmami 3D, które będzie można ściągać na smartfony i inne urządzenia pozwalające odtwarzać filmy wytwarzane w tej technice obrazu. Google wprowadził w swoich smartfonach technologię Google Wallet tj. technologię płatności przez to urządzenie i kartę rabatową Google Offers. Partnerem projektu jest system kart płatniczych Mastercard.

Google wraz z Samsungiem rozpoczyna oferowanie tzw. CHROMEBOOK-ów. Są to laptopy pozbawione tradycyjnego systemu operacyjnego i które mogą nie posiadać również dysku. Są one przystosowane do pracy w tzw. „chmurze komputerów”. Chromebook jest to urządzenie, gdzie wszystkie aplikacje potrzebne użytkownikowi znajdują się w sieci. Jeśli uda się je rozpowszechnić to systemy operacyjne oparte na programach Microsoftu przestaną mieć znaczenie.

Aby zrealizować projekty techniczne przedstawione powyżej konieczna stała się rozbudowa szybkich sieci, którymi są sieci światłowodowe. W 2008 roku największy udział sieciach światłowodowych podłączonych bezpośrednio do budynków lub odbiorców końcowych ( sieć typu FTTH lub FTTB ) miała Korea Południowa 45%, Japonia, 25 % i Tajwan 12 %. W 2010 r. firma Gogle zapowiedziała podłączenie do końca roku pół miliona odbiorców, pracujących na superszybkim Internecie z prędkością 1GB/s - rozpoczął się w ten sposób boom na szybkie sieci światłowodowe pracujące z prędkością około 100 razy większą od prędkości klasycznego Internetu szerokopasmowego. Do końca 2010 roku najwięcej takich sieci powstało w USA, w Europie w Skandynawii, państwach bałtyckich, a nawet w sąsiedniej niewielkiej Słowacji - w Polsce do tej pory nie ma takich sieci. Najnowocześniejsze szybkie sieci światłowodowe w technice GPON ( Gigabit Passive Optical Network ) pozwalają przesyłać informacje z niewyobrażalną jeszcze niedawno maksymalną prędkością 2,488 Gbit/s do klienta i 1,244 Gbit/s od klienta przy zasięgu do 20 km w pasywnej technice światłowodowej wymagającej zasilania jedynie punków końcowych, nie zaś punktów pośrednich sieci. Sieci te są w stanie przesłać za pomocą jednego włókna światłowodowego jednocześnie telewizję, Internet i telefonię.

W Polsce planuje się wprowadzić do „Rozporządzenia Ministra Infrastruktury w sprawie warunków technicznych jakim powinny odpowiadać budynki i ich usytuowanie” zapisu, aby nowe budynki były wyposażone w strukturę światłowodową.

Przybywa różnych nowoczesnych urządzeń takich jak np. Smartfony, które łącząc w sobie funkcje telefonu komórkowego i komputera kieszonkowego wymagają transferu około 4-5 GB, stąd ogromnie rośnie zapotrzebowanie na szybkie sieci bezprzewodowe. Przyszłością będzie sieć czwartej generacji 4G o transmisji mobilnej 100Mb/s i transmisji stacjonarnej 1Gb/s. Polska eksperymentalnie jako czwarty kraj na świecie otworzyła sieci w technologii mobilnej LTE, w której szybkość pobierania danych będzie sięgać 326 Mb/s, a szybkość wysyłania 86 Mb/s, przy kanale przesyłu o szerokości 20MHz i modulacji 64QAM w technice MIMO 4x4. Umożliwi to przesyłanie w sieci mobilnej multimediów. Sieć mobilna LTE nie jest to jeszcze w pełni siecią 4G, gdyż nie spełnia ona warunku 100 Mb/s wysyłania informacji od klienta i stąd nazywana jest technologią 3,9G. Warunek sieci 4G będzie spełniała technologia LTE-Advenced, o prędkości transmisji do klienta downlink 1Gb/s i prędkości od klienta uplink 500 Mb/s. Eksperymentalna sieć w tej technologii ma być uruchomiona jeszcze tego roku w Japonii, a komercyjne uruchomienie technologii planowane jest w 2015 roku. Wg opublikowanych danych na świecie sieci LTE działają obecnie w 14 krajach w tym w Polsce, a 208 operatorów w 80 krajach rozpoczęło inwestycje w tą nowoczesną technologię.

W związku z planowanym wzrostem ruchu w sieci powstała nowa technologia FEMTOKOMÓRKI polegająca na tym, że łączność z odbiorcami przebywającymi w budynkach odbywać się będzie nadal bezprzewodowo, ale na odcinku pomiędzy budynkiem i stacją bazową po szkieletowej sieci światłowodowej. W ten sposób użytkownicy sieci przebywający w budynkach będą komunikować się poprzez szkieletowe sieci światłowodowe, zaś użytkownicy mobilni w dotychczasowy

sposób. Dzięki temu przewiduje się znacznie zmniejszenie liczby odbiorców faktycznie mobilnych, co zmniejszy zajętość pasma i zwiększy możliwości transmisyjne sieci mobilnej, a w ten sposób pozwoli przesyłać ogromne ilości informacji.

Na zakończenie prelekcji został rozstrzygnięty konkurs firmy DIPOL - tuner DVB- T otrzymała sierotka konkursu, którą był prof. Marian Strzała emerytowany profesor szkoły średniej, ponieważ wśród uczestników losowania nie padła poprawna odpowiedź na pytanie jakie jest magiczne 10 literowo słowo kluczowe dla najnowszych projektów przesyłu i przekazu informacji - tym słowem okazała się TRANSMISJA.

W TDE miała wziąć udział jeszcze firma Agro-Film z referatem „Recykling sprzętu RTV I AGD”, która niestety nie przybyła z przyczyn niezależnych od organizatorów. Miejmy nadzieję, że w przyszłym roku uda się nam wysłuchać informacji związanych z ochroną naszego naturalnego środowiska, w którym żyjemy, a które jest zaśmiecane przez miliony zużytych telefonów, telewizorów, radioodbiorników, komputerów i całej masy innego sprzętu użytkowanego na co dzień w naszych gospodarstwach domowych.

W przerwach prelekcji i na zakończenie towarzyszyła uczestnikom TDE świetna i żywa klasyczna muzyka gitarowa w wykonaniu specjalnie zaproszonego na tą okoliczność solisty Piotra Resteckiego, która tworzyła w auli PWSZ pogodny i ciepły nastój.

Tematyka tych dwóch dni była bardzo różnorodna i zapewne poprzez to ciekawa, również ze względu na przyjętą konwencję i formę. Frekwencja w tym roku była większa niż w roku ubiegłym, choć zapewne organizatorzy chcieliby widzieć znacznie więcej członków SEP-u. Ale za to dopisała nasza tarnowska młodzież.